단일 서버

- 웹 앱, 데이터베이스, 캐시 등이 전부 서버 한 대에서 실행된다.

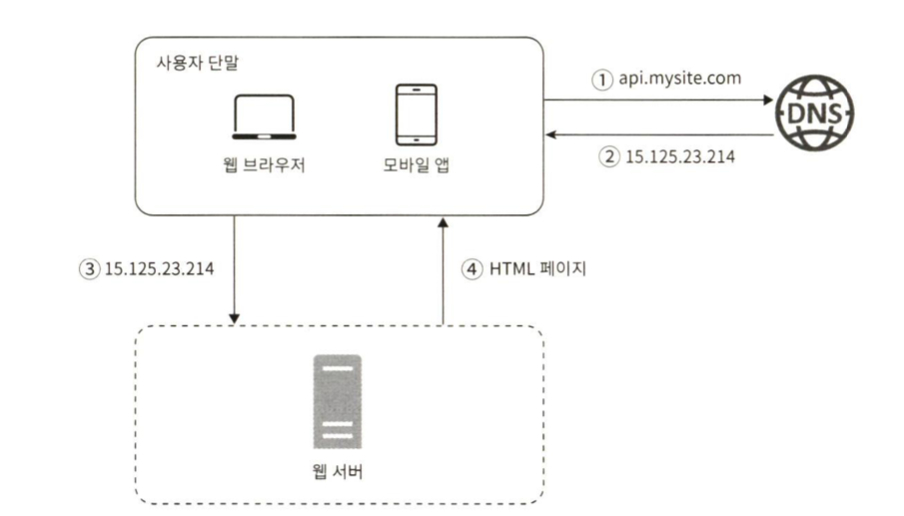

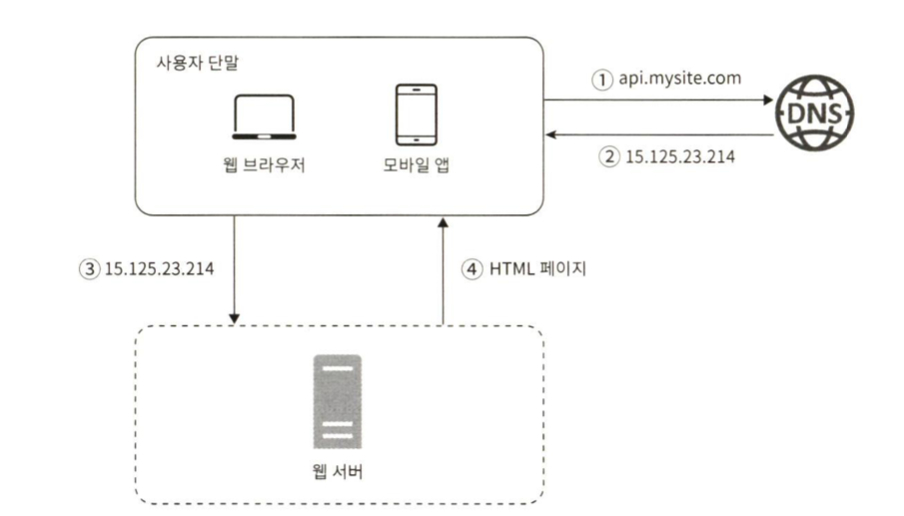

사용자 요청 처리 흐름

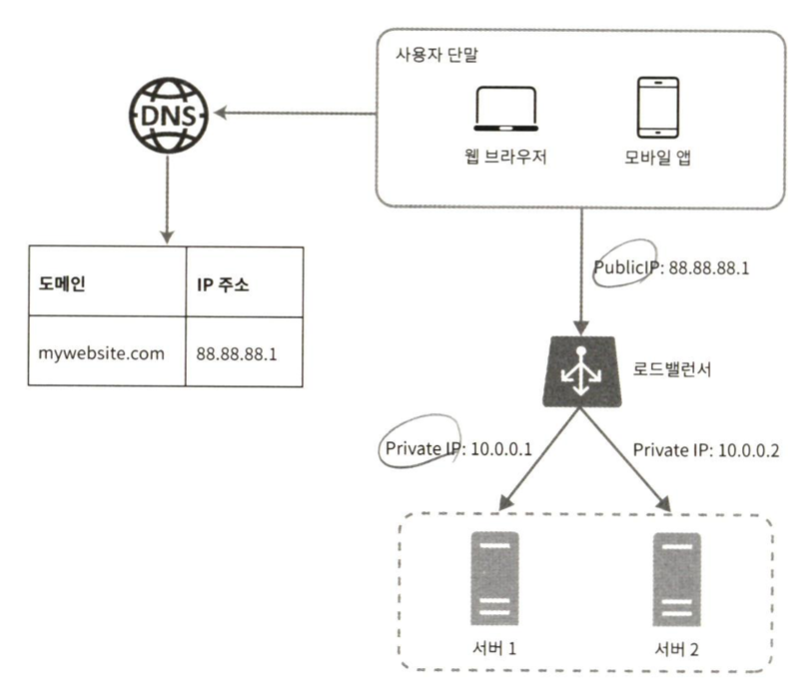

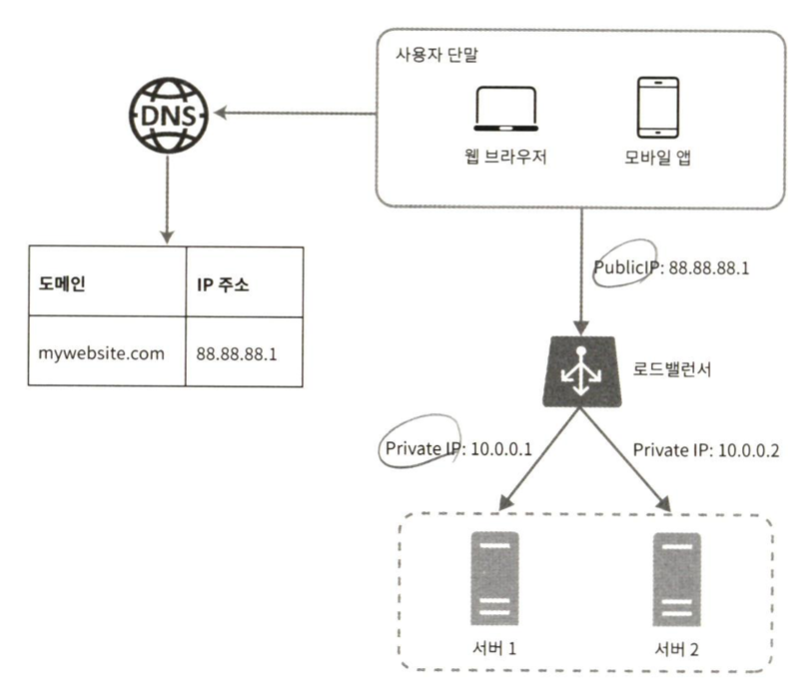

1. 사용자는 도메인 이름(api.mysite.com)을 이용해서 웹사이트에 접속한다. 이 접속을 위해서는 도메인 이름을 DNS에 질의하여 IP 주소로 변환하는 과정이 필요하다.

2. DNS 조회 결과로 IP 주소가 반환된다. (웹 서버의 주소)

3. 해당 IP 주소로 HTTP 요청이 웹 서버에 전달된다.

4. 요청을 받은 웹 서버는 HTML 페이지나 JSON 형태의 응답을 반환한다.

두 가지 종류의 단말으로부터 요청

- 웹 애플리케이션

- 서버 구현용 언어(자바, 파이썬) : 비즈니스 로직, 데이터 저장 처리

- 클라이언트 구현용 언어(HTML, JS) : 프레젠테이션용

- 모바일 앱

- HTTP 프로토콜 이용 : 모바일 앱과 웹 서버 간 통신

- JSON 데이터 포맷 사용

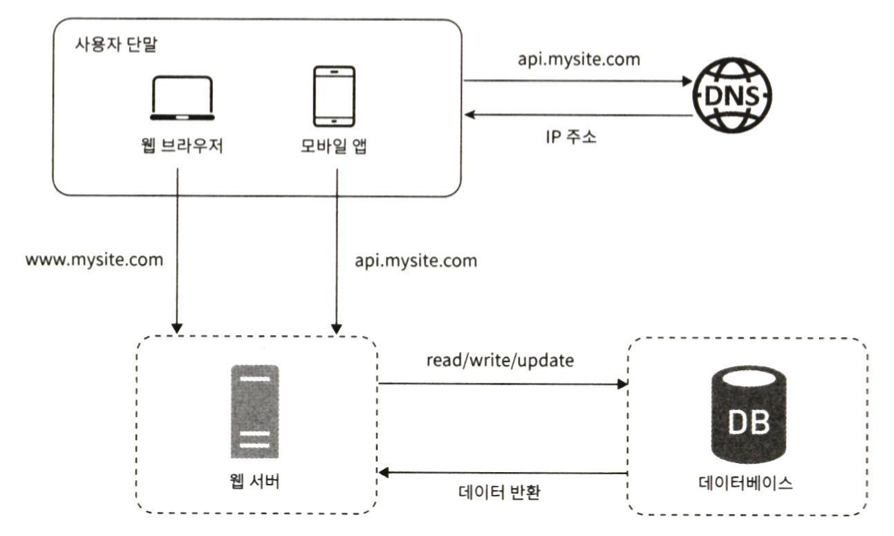

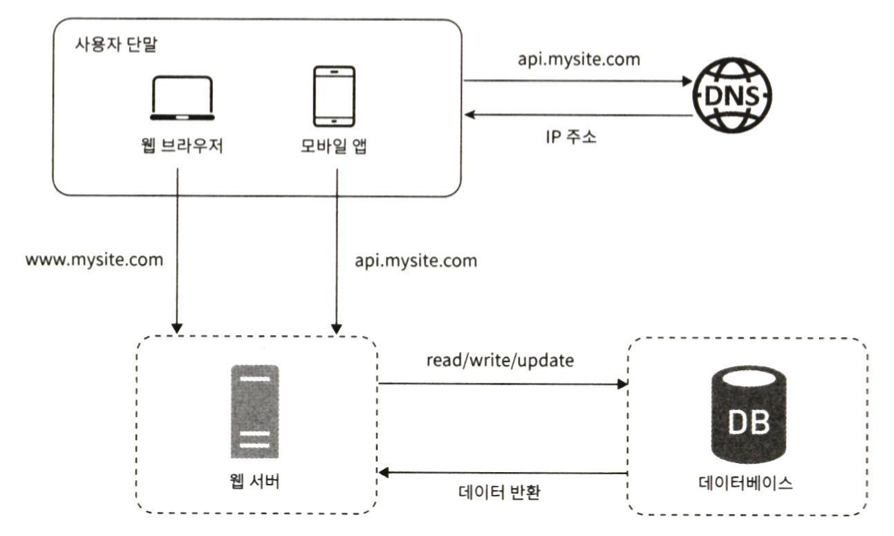

데이터베이스

- 사용자가 증가할 경우, 하나의 서버로는 부족해진다. 여러 서버를 두어야 한다.

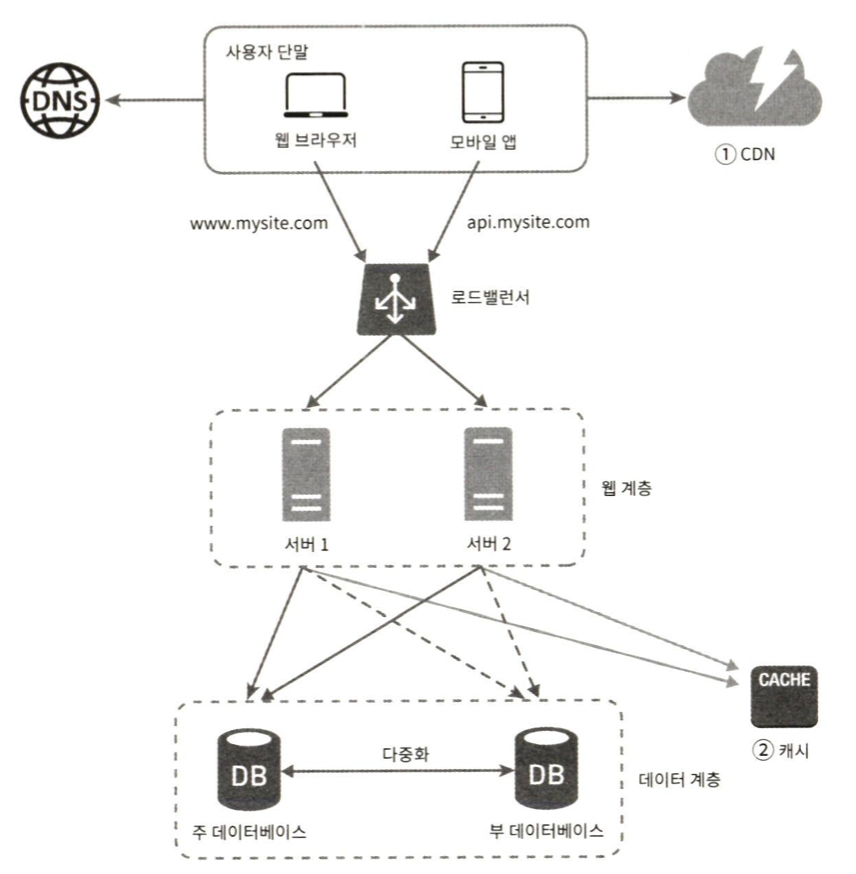

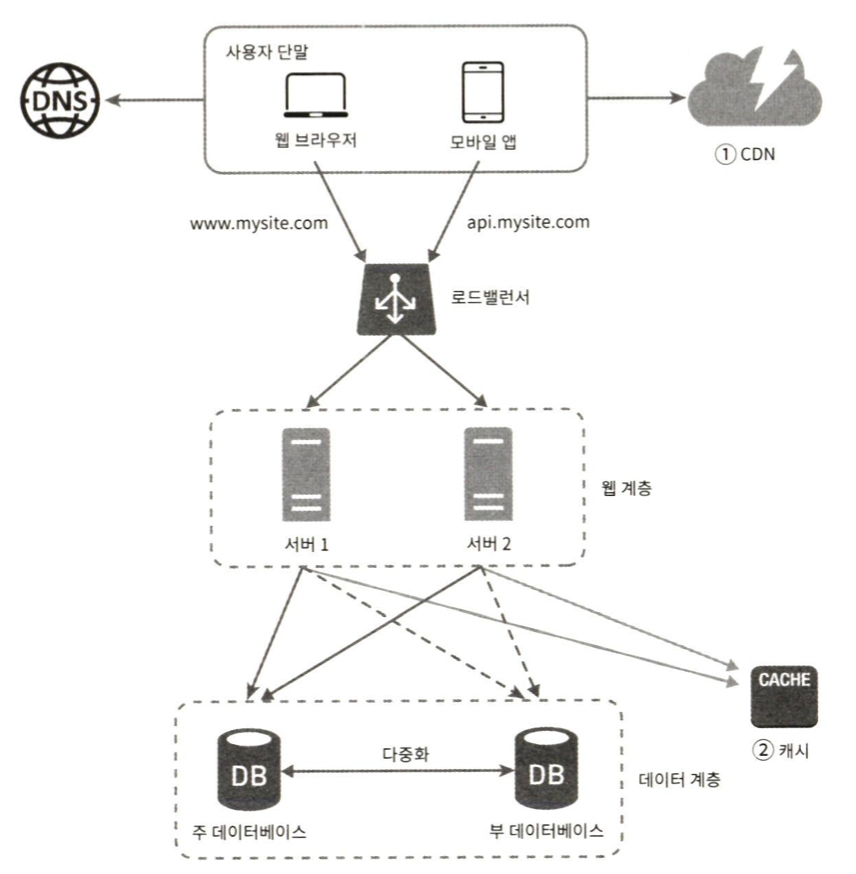

- 아래 그림은 웹/모바일 트래픽 처리(웹 계층)와 데이터베이스(데이터 계층) 용을 따로 분리했다.

데이터베이스의 종류

- 관계형 데이터베이스(Relational Database)

- MySQL, Oracle, PostgreSQL

- 테이블, 열, 칼럼

- join 지원

- 비-관계형 데이터베이스(NoSQL)

- CouchDB, Neo4j, Cassandra, HBase, Amazon DynamoDB

- NoSQL의 4가지 분류

- 키-값 저장소(key-value store)

- 그래프 저장소(graph store)

- 칼럼 저장소(column store)

- 문서 저장소(document store)

- join 지원 X

NoSQL 활용 예시

- 아주 낮은 응답 지연시간(latency) 요구되는 경우

- 다루는 데이터가 비정형(unstructured)이라 관계형 데이터가 아니다.

- 데이터(JSON, YAML, XML 등)를 직렬화하거나(serialize) 역직렬화(deserial-ize)할 수 있기만 하면 된다.

- 아주 많은 양의 데이터를 저장해야 하는 경우

수직적 규모 확장 vs 수평적 규모 확장

- 수직적 확장 : 서버로 유입되는 트래픽 양이 적을 때

스케일 업(scale up)

- 수직적 규모 확장 프로세스

- 서버에 고사양 자원(더 좋은 CPU, 더 많은 RAM)을 추가하는 행위

- 단점

- 확장의 한계, 한 대의 서버에 CPU나 메모리를 무한대로 증설 불가능

- 장애에 대한 자동복구나 다중화 방안을 제시하지 않는다. -> 장애 시 웹 사이트의 완전 종료

스케일 아웃(scale out)

- 수평적 규모 확장 프로세스

- 더 많은 서버를 추가하여 성능 개선하는 행위

- 수직적 규모 확장 프로세스의 단점으로 대규모 애플리케이션을 지원하는 데 수평적 규모 확장 프로세스를 사용한다.

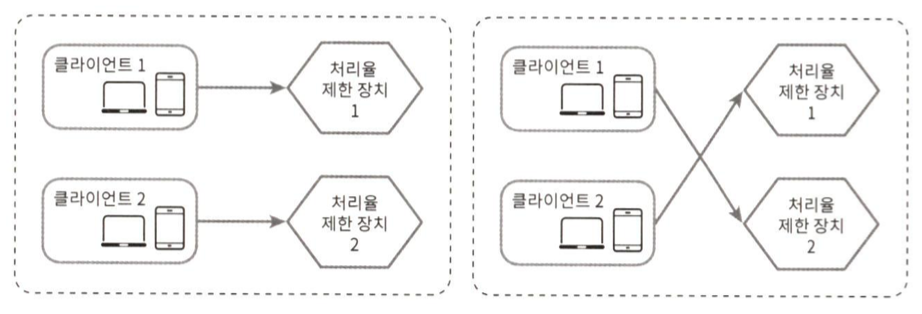

로드밸런서(load balancer)

- 부하 분산 집합에 속한 웹 서버들에게 트래픽 부하를 고르게 분산하는 역할

- 너무 많은 사용자가 접속하거나 웹 서버가 한게 상황에 도달하면 응답 속도가 느려지거나 서버 접속이 불가능해질 수 있다. -> 로드밸런서 도입

- 사용자는 로드밸런서의 공개 IP 주소로 접속해 웹 서버는 클라이언트의 접속을 직접 처리하지 않는다.

- 보안 향상을 위해 서버 간 통신에는 사설 IP 주소를 이용함으로싸, 인터넷을 통해서 접속하지 못하게 한다. 로드밸런서는 웹 서버와 통신하기 위해 이 사설 주소를 사용한다.

- 로드 밸런서는 자동적으로 트래픽을 분산해주기 때문에 서버1이 다운되면, 모든 트래픽은 서버2로 전송한다.

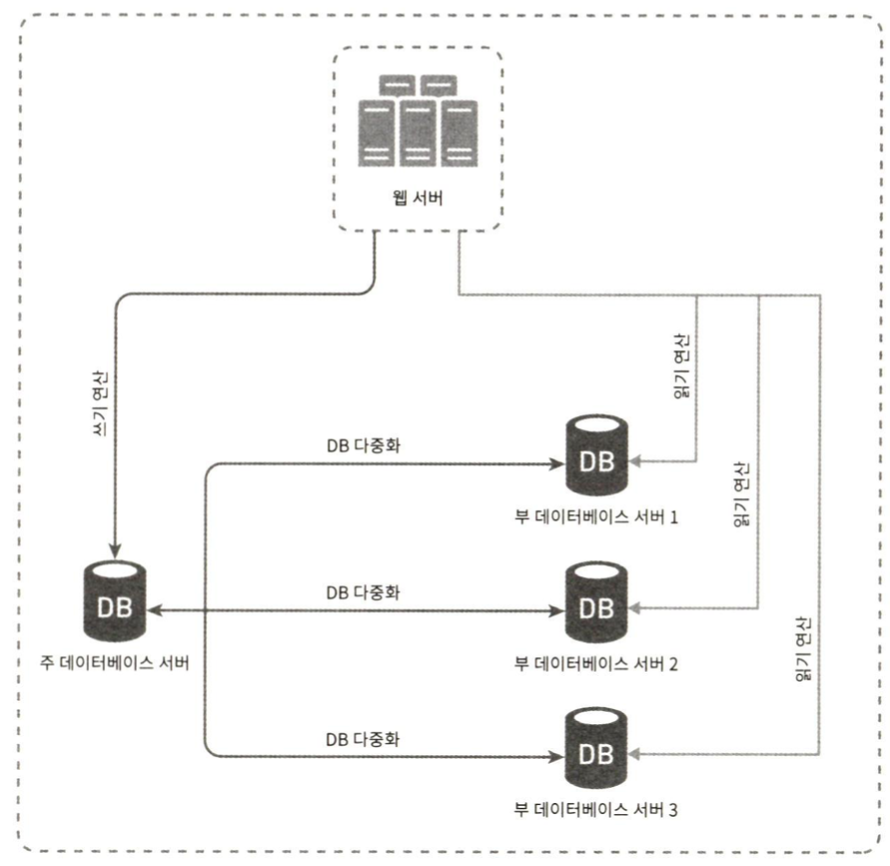

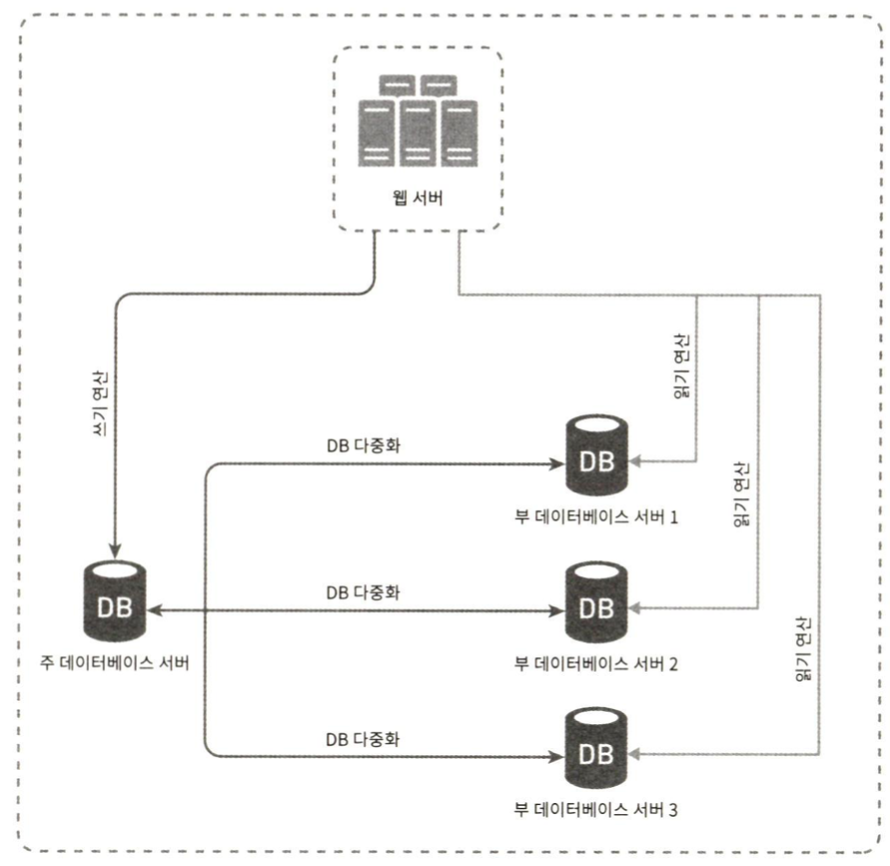

데이터베이스 다중화

- 데이터 계층의 문제 해결 방법

- 서버 사이에 주(master)-부(slave) 관계를 설정하고 데이터 원본은 주 서버에, 사본은 부 서버에 저장하는 방식

- 주 서버 : 쓰기 연산, insert, delete, update

- 부 서버 : 주 서버의 사본을 전달받고, 읽기 연산만 지원

- 대부분의 애플리케이션은 쓰기 연산 < 읽기 연산

- 주 서버보다 부 서버의 수가 더 많다.

- 다중화의 장점

- 더 나은 성능 : 주-부 다중화 모델에서 쓰기 연산은 주 데이터베이스 서버로, 읽기 연산은 부 데이터베이스 서버로 분산된다. 병렬로 처리될 수 있는 질의(query) 수가 늘어나 성능이 향상된다.

- 안정성 : 데이터베이스 서버 가운데 일부가 파괴되도 데이터의 보존이 가능하다.

- 가용성 : 여러 지역에 데이터를 복사해서, 하나의 데이터가 장애가 발생해도 다른 서버에서 복구 가능

- 주 서버가 다운될 경우?

- 부 서버가 일시적으로 주 서버가 되고, 부 서버에 보관되었던 데이터가 최신 상태가 아닐 수 있을 경우에는 복구 스크립트(recovery script)를 돌려서 부족한 데이터를 추가해준다.

- 사용자는 DNS에서 로드밸런서의 public IP를 발급

- 사용자는 해당 IP 주소로 로드밸런서에 접속

- HTTP 요청은 서버 1 or 서버 2로 전달

- 웹 서버는 읽기 연산을 부 데이터베이스 서버로

- 웹 서버는 쓰기 연산을 주 데이터 베이스로 전달

캐시(Cache)

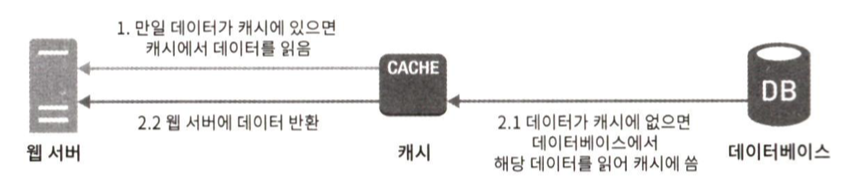

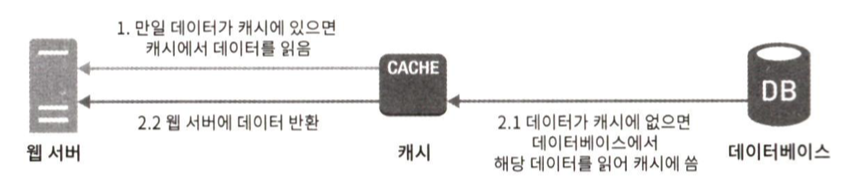

- 실행이 오래걸리는 연산이나 자주 참조되는 데이터를 메모리 안에 두고, 요청이 보다 빨리 처리될 수 있도록 하는 저장소

- 애플리케이션의 성능은 데이터 베이스를 얼마나 자주 호출하느냐에 따라 크게 달라진다.

- 응답 시간 개선 : 캐시(cache)를 붙이고 정적 콘텐츠를 콘텐츠 전송 네트워크(Content Delivery Network, CDN)으로 이동

캐시 계층(Cache tier)

- 데이터가 잠시 보관되는 곳. 데이터베이스보다 빠르다.

- 데이터베이스 부하를 줄일 수 있고, 캐시 계층의 규모를 독립적으로 확장 가능

- 읽기 주도형 캐시 전략(read-through caching strategy) : 웹 서버는 캐시에 응답이 있는지 확인 후, 데이터가 있으면 반환한다. 없으면 데이터베이스에 query로 데이터를 찾아 캐시에 저장한 후 클라이언트에 반환

- 캐시 서버 이용 방법 - memcached API 사용

SECONDS = 1

cache.set('myKey', 'hi there', 3600 * SECONDS)

cache.get('myKey')

캐시 사용 주의 사항

- 참조가 빈번하게 일어나는 경우

- 캐시는 휘발성 메모리이기 때문에, 중요 데이터는 지속성 저장소(persistent data store)에 저장

- 캐시 만료 기준 : 적절한 정책으로 만료 기한을 설정한다.

- 일관성(consistency) : 데이터 저장소의 원본과 캐시 내의 사본이 같은지?

- 저장소의 원본을 갱신하는 연산 = 캐시를 갱신하는 연산이 단일 트랜잭션으로 처리되어야 한다.

- 캐시 서버를 하나만 둘 경우, 단일 장애 지점(Single Point of Failure, SPOF)이 되어버릴 수 있다. 전체 시스템이 동작 중지가 될 수 있기 때문에 여러 지역에 걸쳐 캐시 서버를 분산해야 한다.

- 캐시 메모리를 너무 작게 잡을 경우, 데이터가 캐시에 자주 밀려나는 문제가 생긴다. 이 경우 캐시 메모리를 과할당(overprovision)한다.

- 데이터 방출 정책을 적절하게 적용

- LRU(Least Recently Used) : 사용이 가장 오래된 데이터부터 내보낸다.

- LFU(Least Frequently Used) : 사용 빈도가 가장 낮은 데이터부터 내보낸다.

- FIFO(First In First Out) : 가장 먼저 들어온 데이터를 가장 먼저 내보낸다.

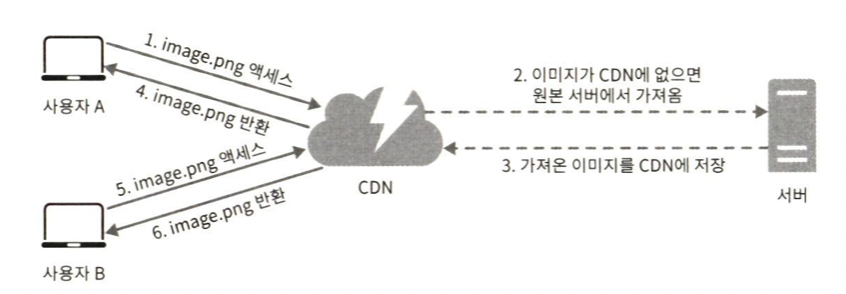

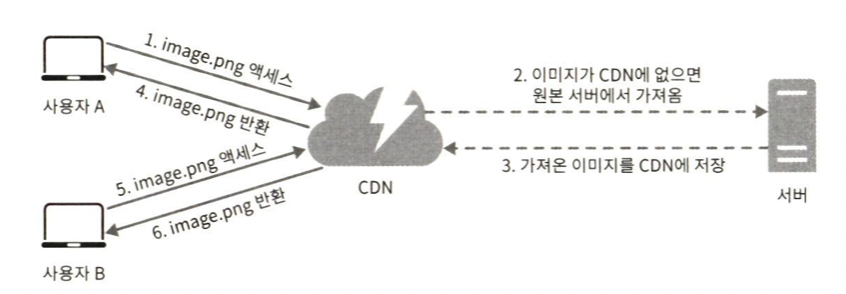

콘텐츠 전송 네트워크(CDN)

- CDN : 정적 콘텐츠를 전송하는 데 쓰이는 지리적으로 분산된 서버의 네트워크

- 동적 콘텐츠 캐싱 : request path, query string, request header, 쿠키 등의 정보에 기반하여 HTML 페이지를 캐시하는 것

CDN 동작 과정

- 사용자가 웹사이트 방문시, 사용자에게 가까운 CDN 서버가 정적 콘텐츠를 전달한다.

- 정적 콘텐츠 : js, css, 이미지 등등

1. 사용자 A 가 이미지 URL으로 image.png에 접근한다. (URL 도메인은 CDN 서비스 사업자가 제공)

2. CDN 서버의 캐시에 해당 이미지가 없는 경우, 서버는 원본 서버에 요청하여 파일을 가져온다.

3. 원본 서버가 파일을 CDN 서버에 반환. (응답 HTTP header에 파일이 언제까지 캐시될 수 있는지 TTL(Time-To-Live)값이 있다.)

4. CDN 서버는 파일을 캐시하고 사용자 A에게 반환. 이미지는 TTL에 명시된 시간까지 캐시

5. 사용자 B가 같은 이미지에 대한 요청을 CDN 서버에 전송

6. 만료되지 않은 이미지에 대한 요청은 캐시를 통해 처리된다.

CDN 사용 고려 사항

- 비용 : CDN은 보통 제 3 사업자(third-party providers)가 운영한다. CDN에 들어가고 나오는 데이터의 전송 양에 따라 비용을 내기 때문에, 자주 사용되지 않는 콘텐츠는 CDN에서 뺸다.

- 적절한 만료 시한 설정 : 시의성이 중요한(time-sensitive) 콘텐츠는 만료 기간을 잘 정해야 한다.

- CDN 장애에 대한 대처 방안 : CDN 자체가 죽을 경우, 웹사이트/애플리케이션이 어떻게 동작해야 하는지 고려하기 -> 원본 서버로부터 직접 콘텐츠를 가져오도록 클라이언트 구성

- 콘텐츠 무효화(invalidation) 방법 : 아직 만료되지 않은 콘텐츠를 CDN에서 제거할 때 사용

- CDN 서비스에서 제공하는 API 사용

- 콘텐츠의 다른 버전을 서비스하도록 오브젝트 버저닝(object versioning) 이용 -> image.png?v=2

CDN + Cache

- CDN : 정적 콘텐츠는 웹 서버를 통해 서비스하지 않고, 성능 개선

- Cache : 데이터베이스 부하 감소

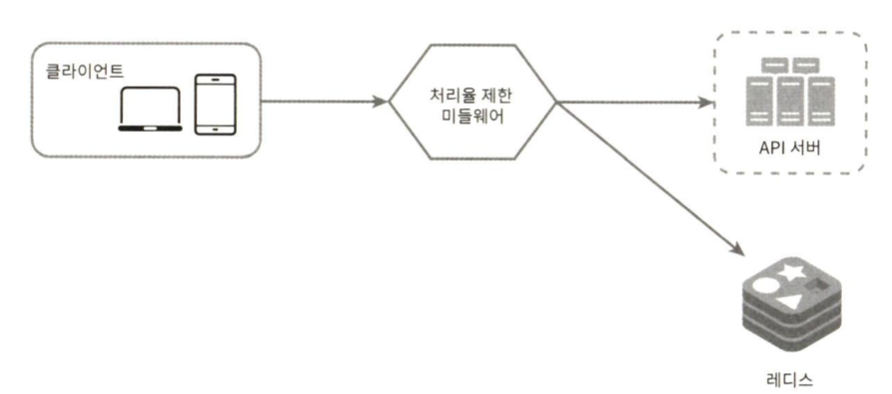

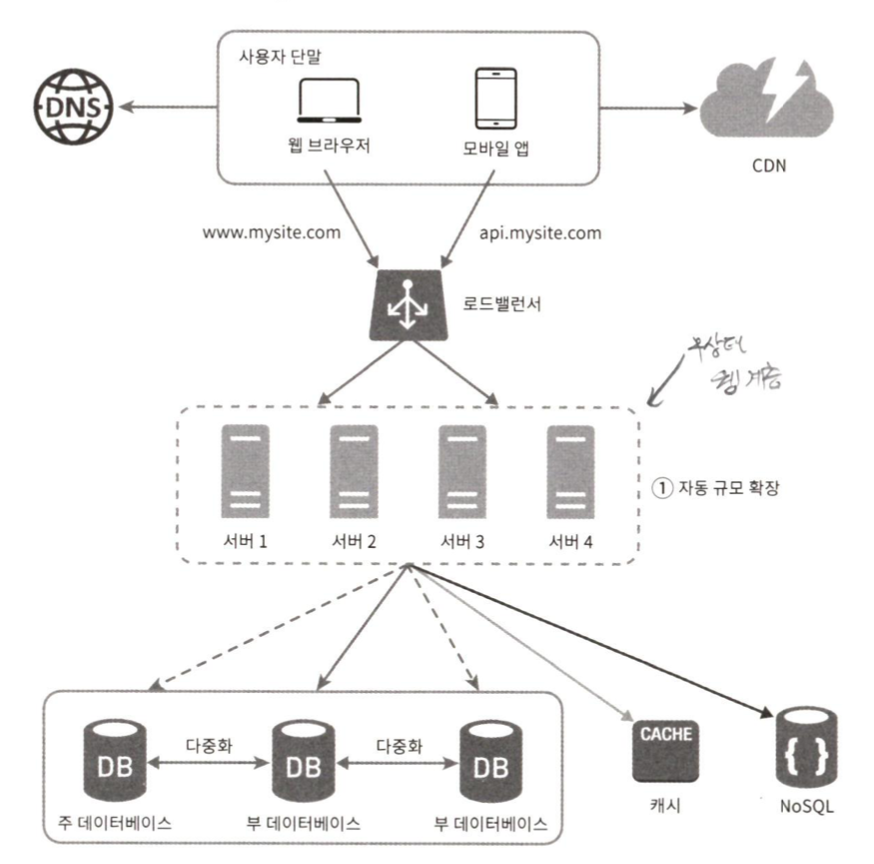

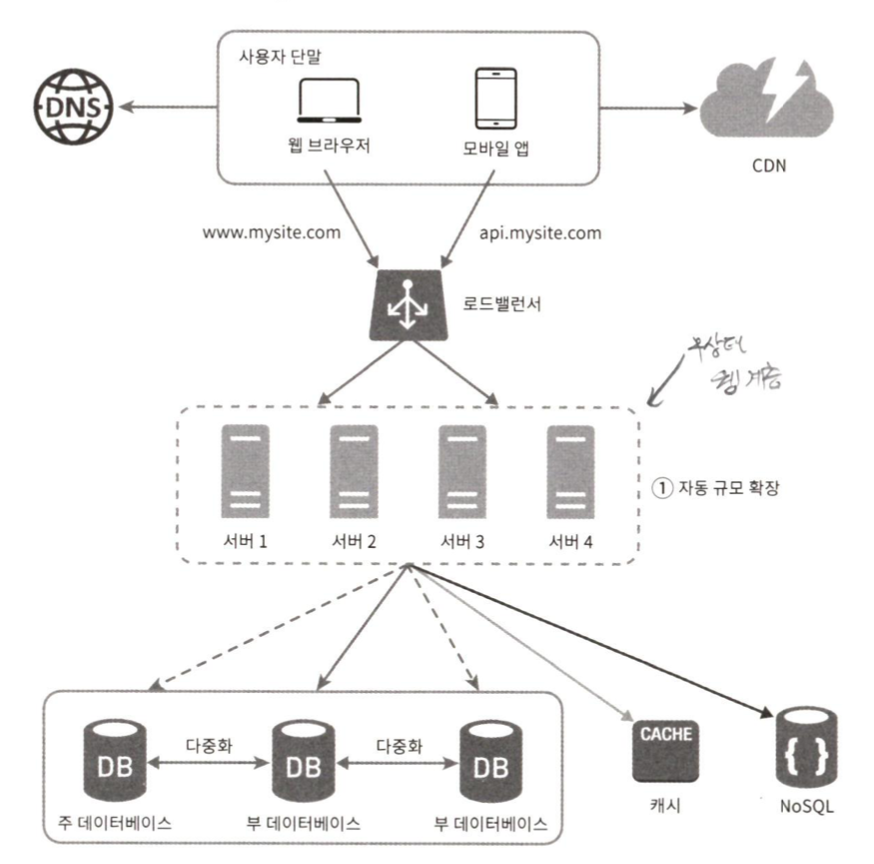

무상태(stateless) 웹 계층

- 웹 계층을 수평적으로 확장하기 위해서는 상태 정보(사용자 세션 데이터 등등)를 웹 계층에서 제거해야 한다.

- 무상태 웹 계층 : 상태 정보를 RDBMS, NoSQL 같은 지속성 저장소에 보관하고, 필요할 때 가져온다.

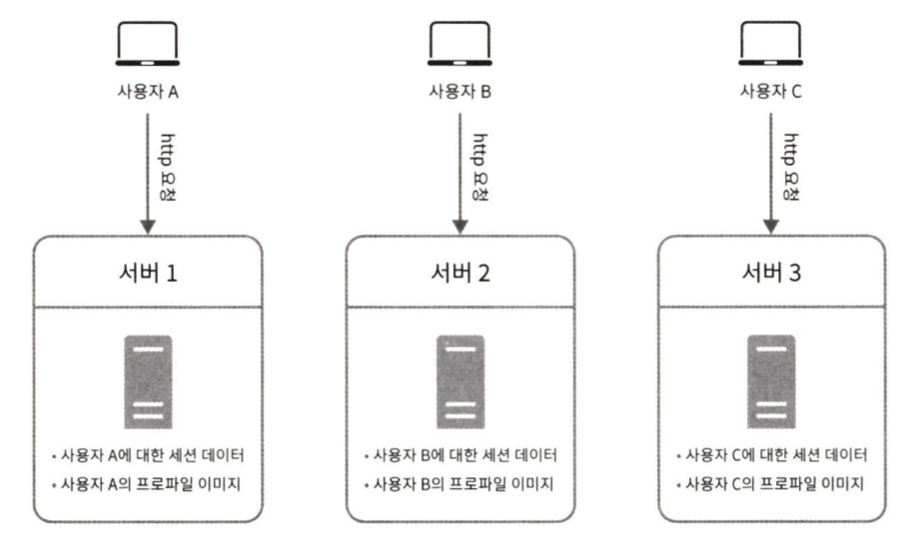

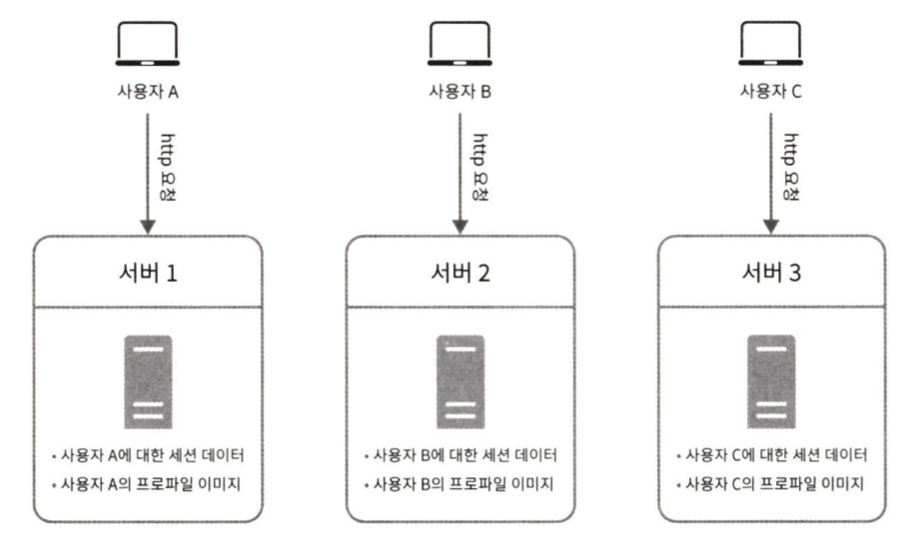

상태 정보 의존적인 아키텍처

- 상태 정보 보관 서버 : 클라이언트 정보(상태 유지)로 요청들 사이에 공유

- 사용자 A의 정보는 서버 1에 저장되어 있고, 사용자 A를 인증하려면 HTTP 요청이 서버 1으로 전송해야 한다.

- 같은 클라이언트의 요청은 같은 서버로 전송되어야 하는 문제점 때문에 로드밸런서의 고정 세션(sticky session) 기능을 사용하지만, 부담을 줄 수 있고 확장성에 좋지 않다.

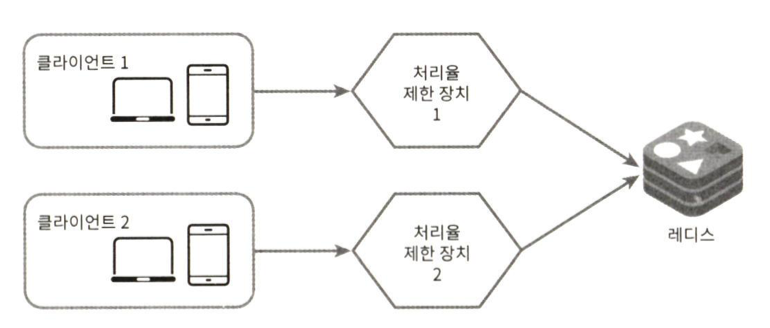

무상태 아키텍처

- 사용자로부터 HTTP 요청은 어떤 웹 서버로도 전달될 수 있기 때문에 상태 정보가 필요한 경우 공유 저장소(shared storage)로부터 데이터를 가져온다.

- 단순한 구조, 안정적, 규모 확장 용이

기존 설계 + 무상태 아키텍처

데이터 센터

- 여러 지역의 사용자가 쾌적하게 사용할 수 있도록 지원해야 할 때 사용한다.

- 지리적 라우팅 : 사용자에게 가장 가까운 데이터 센터로 안내되는 것

- geoDNS는 사용자의 위치에 따라 도메인 이름을 어떤 IP 주소로 변환할지 결정해주는 DNS 서비스

다중 데이터센터 아키텍처 고려사항

- 트래픽 우회 : 올바른 데이터 센터로 트래픽 보내는 방법 찾기

- 데이터 동기화(synchronization)

- 테스트와 배포 : 여러 위치에서 테스트 해보기

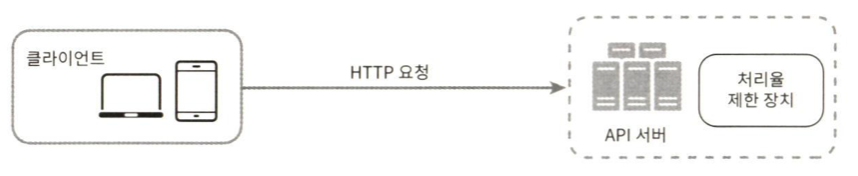

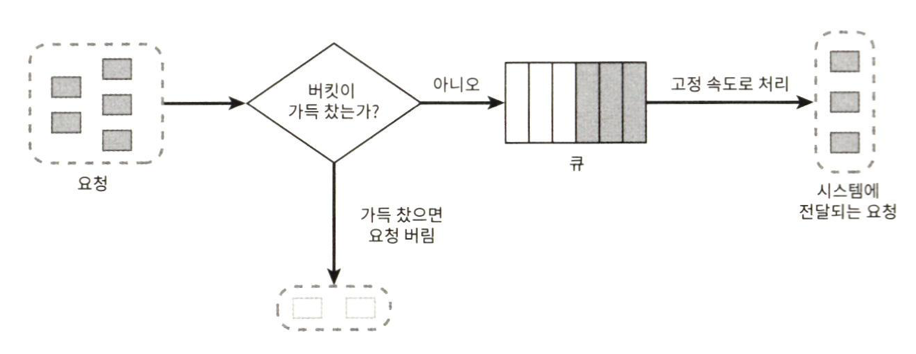

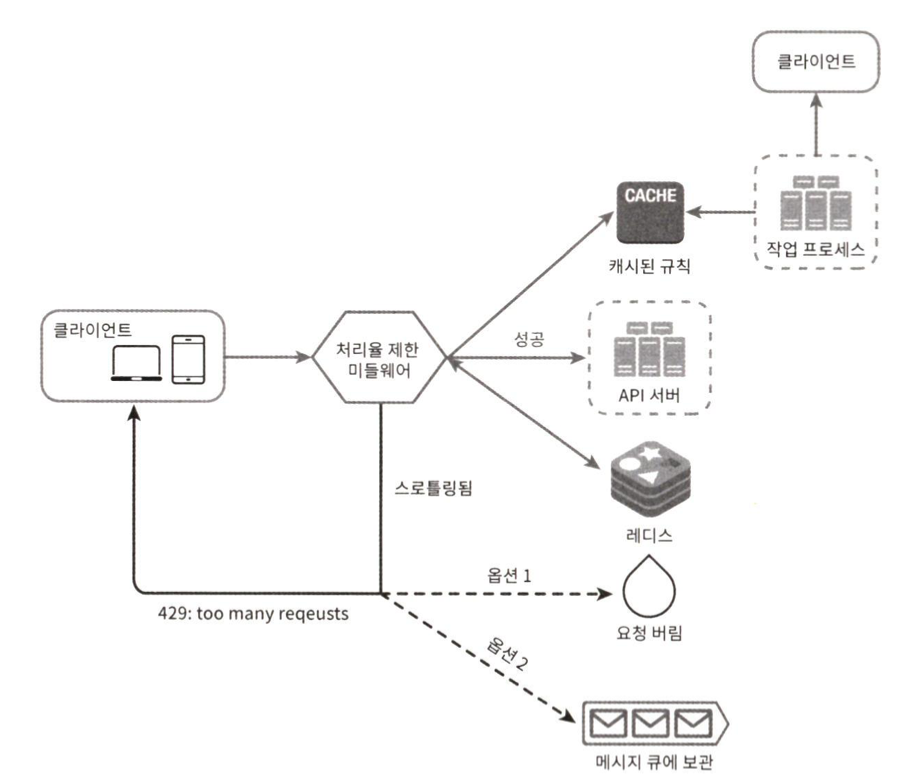

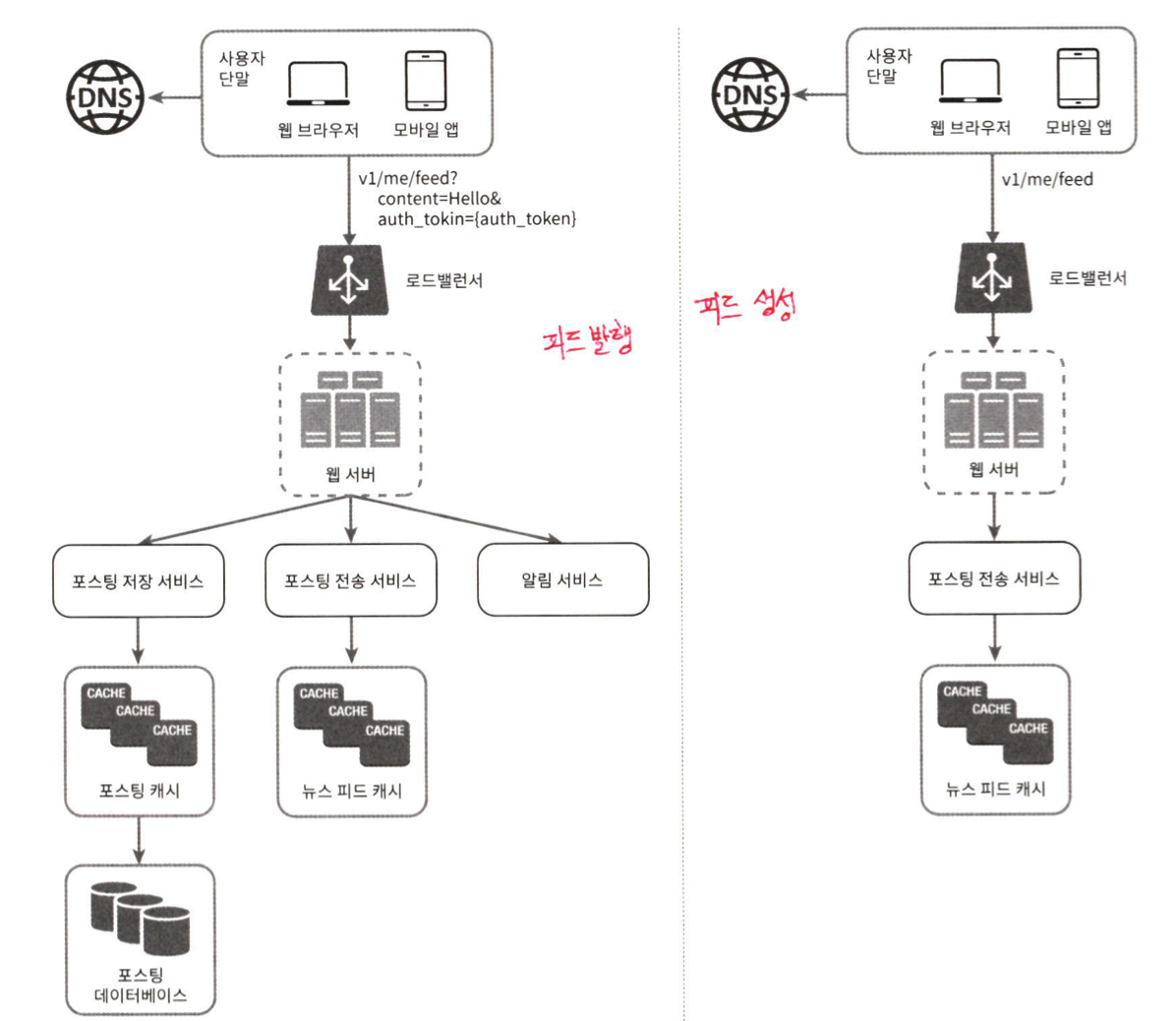

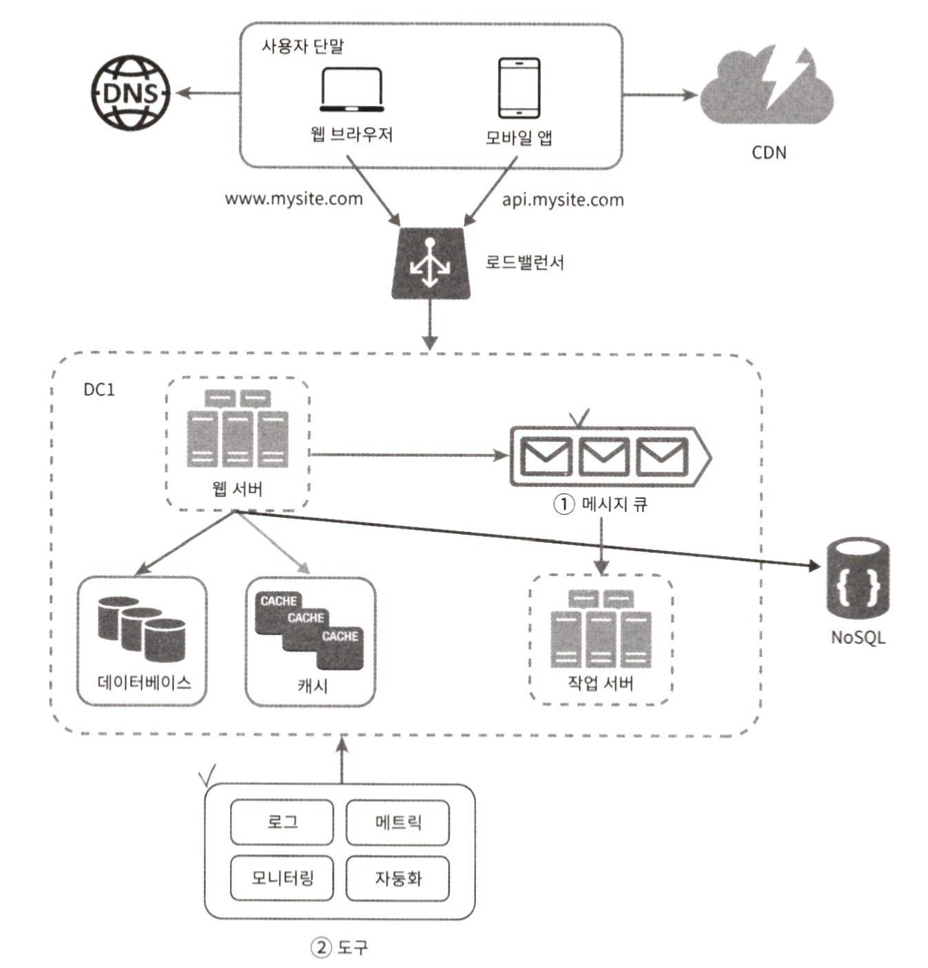

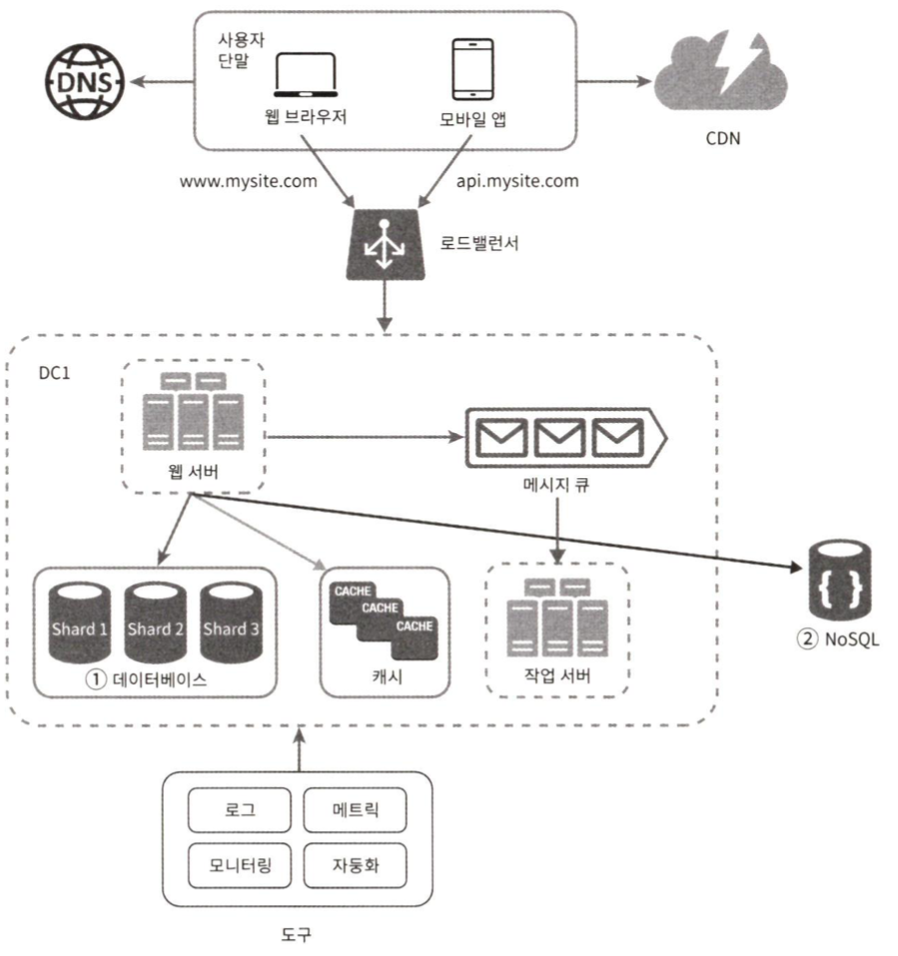

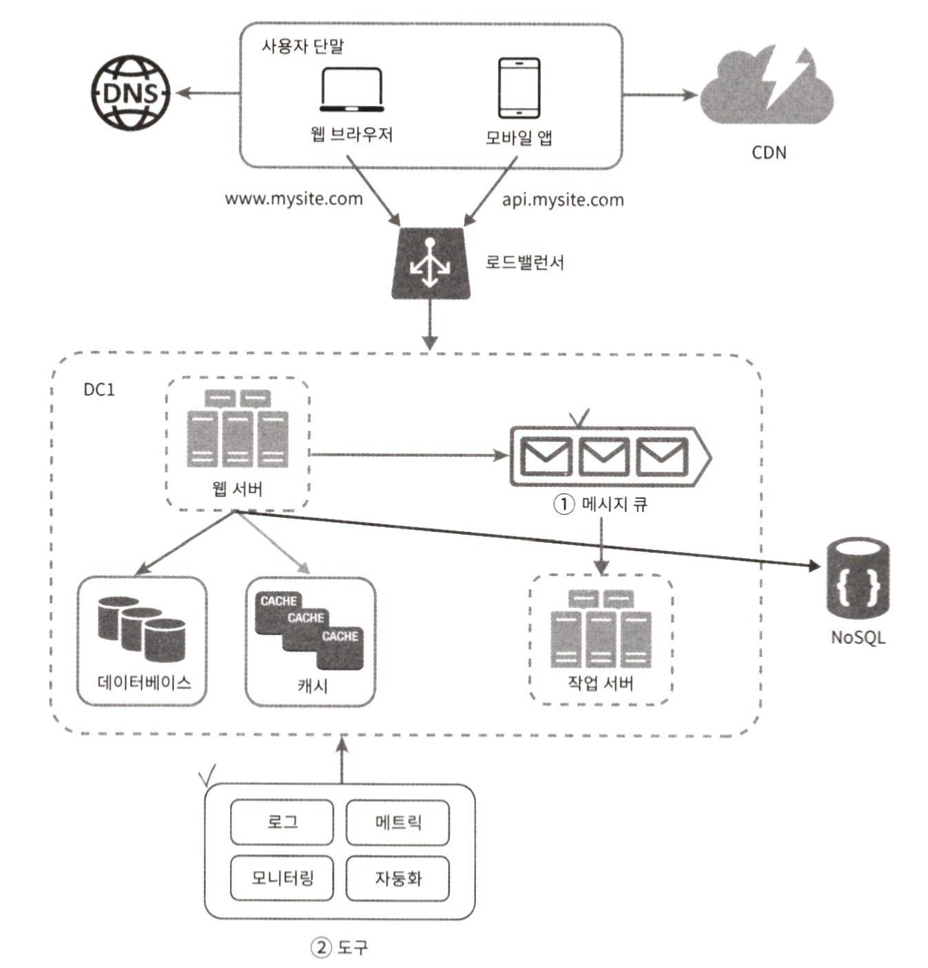

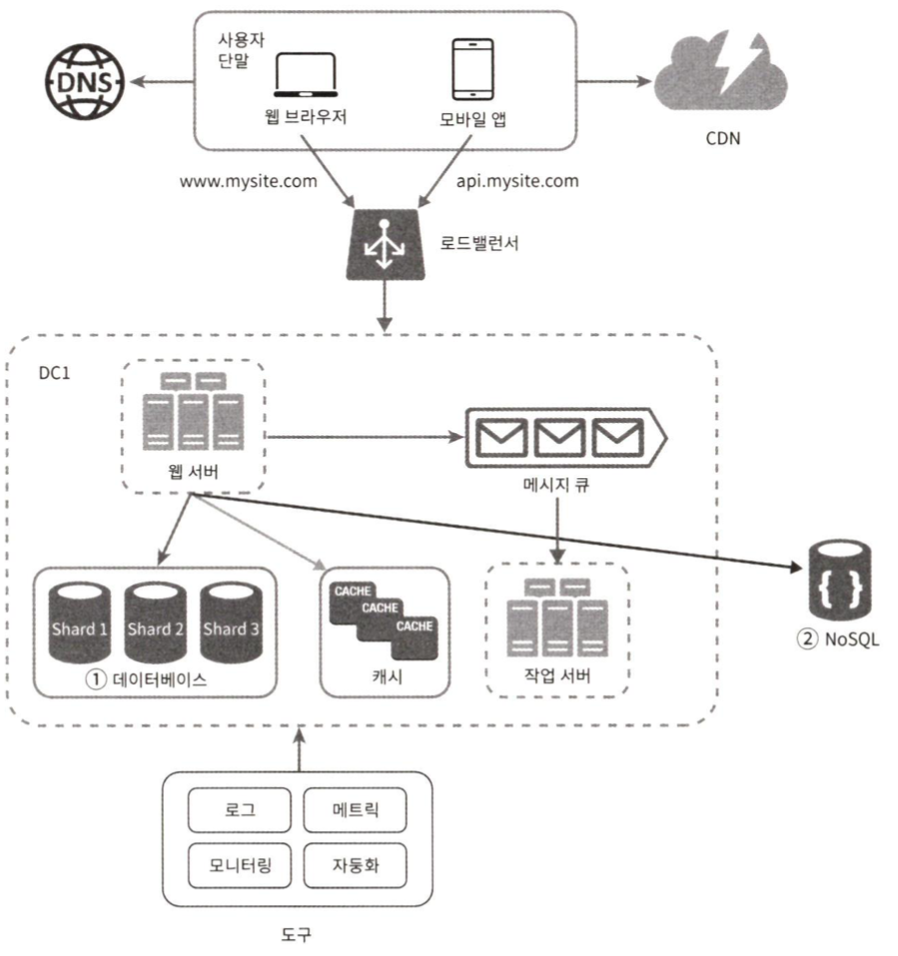

메시지 큐(message queue)

- 시스템을 더 큰 규모로 확장하기 위해 시스템의 컴포넌트를 분리하여 각각 독립적으로 확장될 수 있도록 해야 한다.

- 메시지의 무손실(durability)을 보장하는, 비동기 통신을 지원하는 컴포넌트

- 메시지의 버퍼 역할을 하며, 비동기적으로 전송

- 입력서비스(생산자/발행자)가 메시지를 만들어 메시지 큐에 발행(publish)

- 큐에는 서비스 or 서버(구독자/소비자)가 연결되어 있는데, 메시지를 받아 그에 맞는 동작을 수행한다.

- 생산자 서비스가 가용한 상태가 아니어도 메시지 수신 가능

메시지 큐 사용 예시

- 사진 보정 애플리케이션에서 보정은 시간이 오래 걸릴 수 있는 프로세스이다. -> 비동기적으로 처리하기

- 웹 서버는 사진 보정 작업을 메시지 큐에 넣고

- 사진 보정 작업 프로세스는 메시지 큐에서 꺼내면서 비동기적으로 완료한다.

로그, 메트릭 그리고 자동화

- 로그

- 에러 로그 모니터링은 시스템의 오류와 문제들을 쉽게 찾아낼 수 있다.

- 메트릭

- 잘 수집된 메트릭은 사업 현황에 유용한 정보를 얻을 수 있고, 시스템의 상태를 쉽게 파악 가능하다.

- 호스트 단위 메트릭 : CPU, 메모리, 디스크 I/O

- 종합 메트릭 : 데이터베이스 계층의 성능, 캐시 계층의 성능

- 핵심 비즈니스 메트릭 : 일별 능동 사용자, 수익, 재방문

- 자동화

- 시스템이 복잡해질 때, 개발 생산성을 높이기 위해 사용

기존 설계 + 메시지 큐, 로그, 메트릭, 자동화

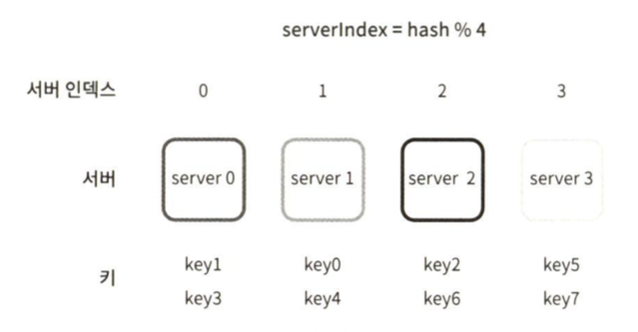

데이터베이스 규모 확장

수직적 확장(Scale up)

- 고성능 자원(CPU, RAM, 디스크) 을 증설하는 방법

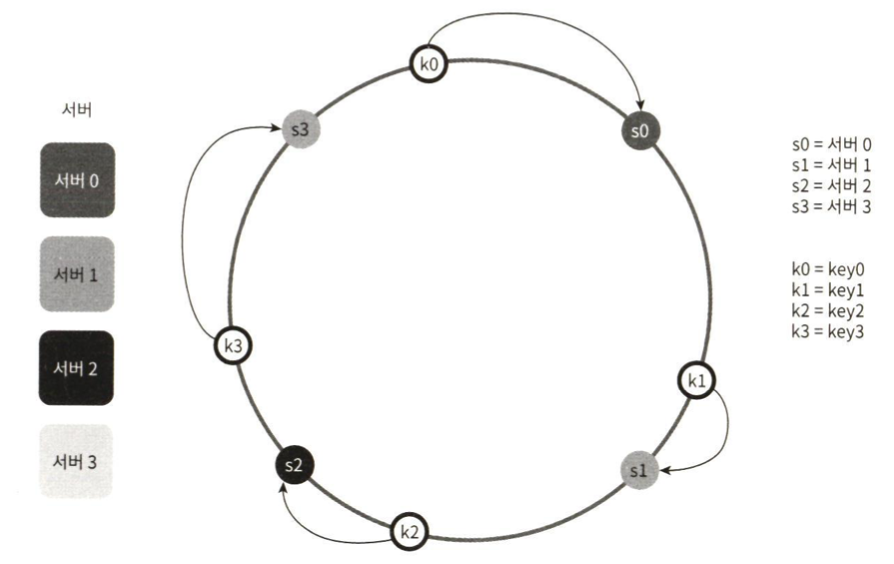

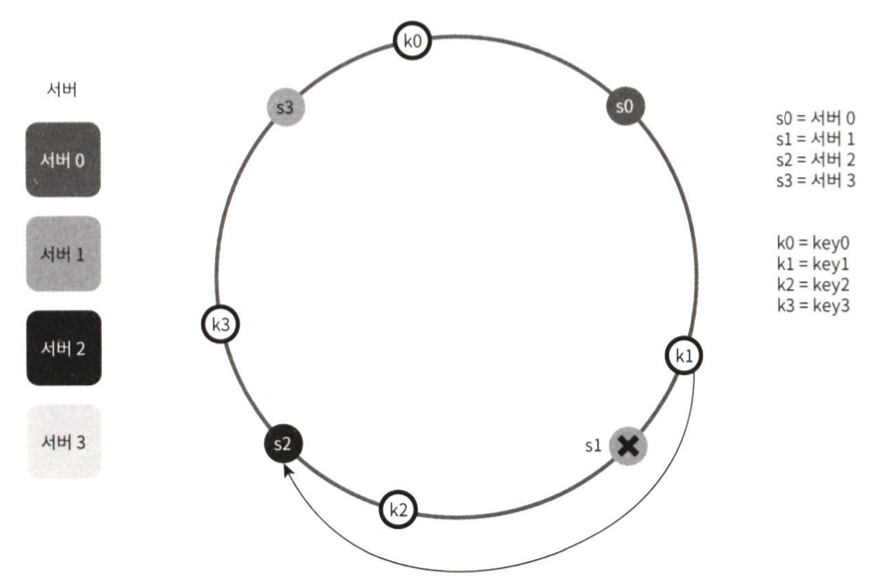

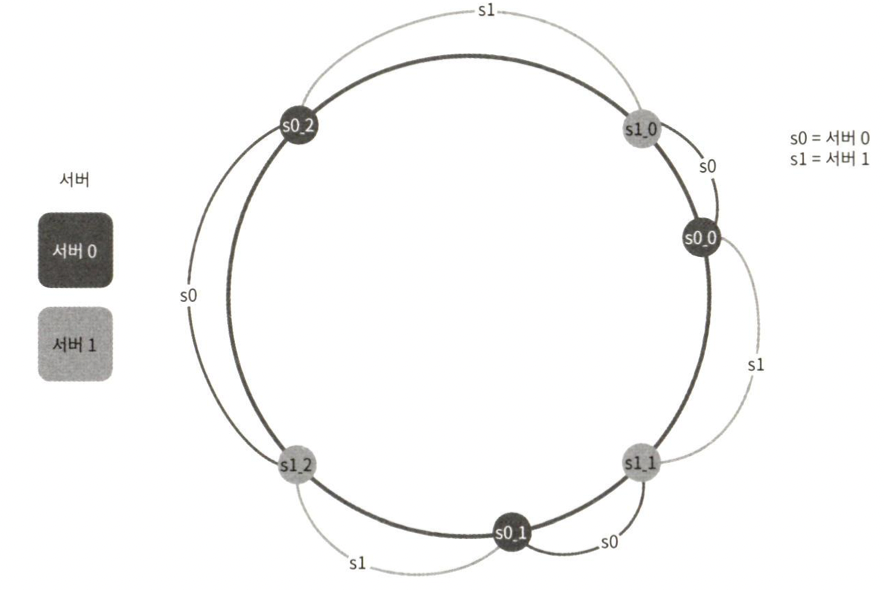

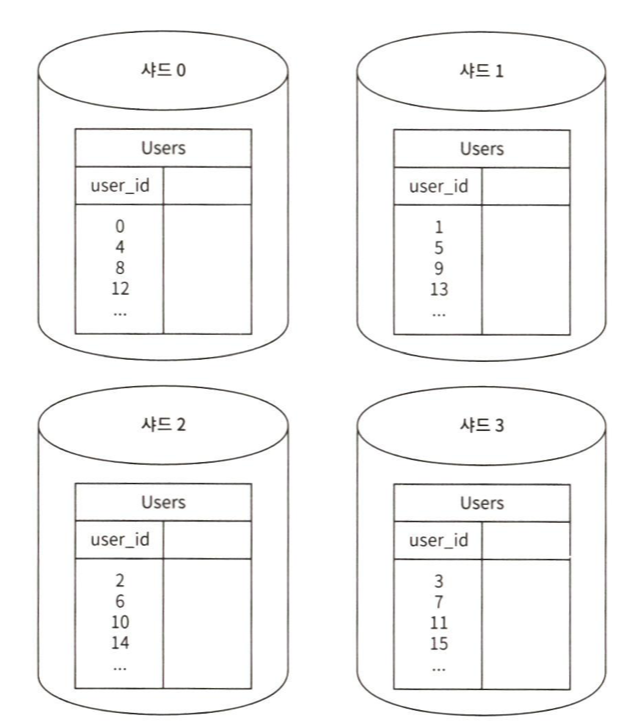

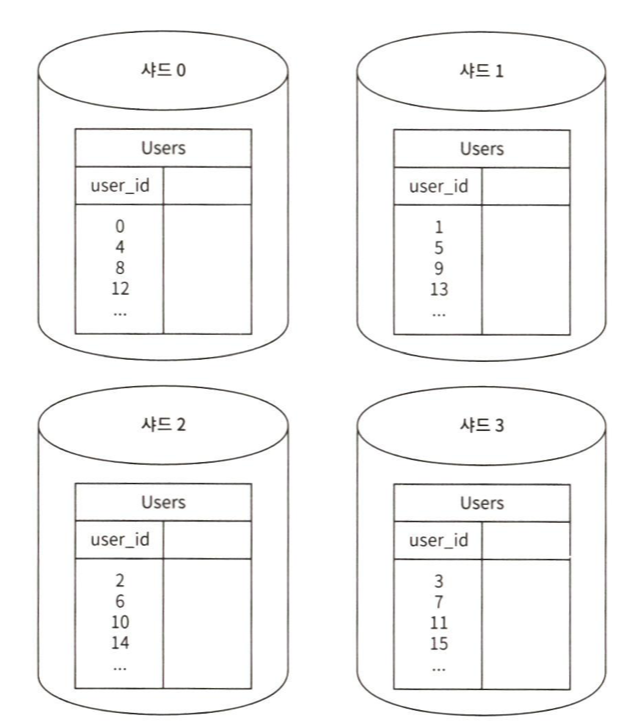

수평적 확장(sharding)

- 더 많은 서버를 추가해 성능 향상

- 샤딩 : 대규모 데이터베이스를 샤드(shard) 단위로 분할하는 기술

- 샤드는 같은 스키마를 사용하지만, 보관되는 데이터는 중복 X

샤딩 전략 고려사항

- 샤딩 키를 어떻게 정하는지?

- 데이터 재샤딩

- 데이터가 너무 많아 하나의 샤드로 불가능한 경우

- 샤드 간 데이터 분포가 균등하지 않은 경우 -> 샤드 소진 현상 발생 -> 샤드 키 계산 함수를 변경한다, 안정 해시 기법

- 유명인사 문제 : 특정 샤드에 질의가 집중되어 서버에 과부하 되는 문제

- 유명인사 각각에 샤드를 하나씩 할당하거나 더 잘개 쪼개주어야 한다.

- 조인과 비정규화

- 하나의 DB를 여러 샤드로 쪼개면, JOIN이 어렵다는 문제가 생긴다.

- DB를 비정규화 하여 하나의 테이블에서 질의가 수행될 수 있도록 해준다.

기존 설계 + RDBMS가 필요 없는 기능 -> NoSQL 이전

백만 사용자, 그리고 그 이상

- 웹 계층은 무상태 계층

- 모든 계층에 다중화 도입

- 가능한 많은 데이터 캐시

- 여러 데이터 센터 지원

- 정적 콘텐츠는 CDN으로 서비스

- 데이터 계층은 샤딩을 통해 규모를 확장하기

- 각 계층은 독립적 서비스로 분할

- 시스템을 지속적으로 모니터링하고, 자동화 도구를 활용하기